LLM 사용에 대한 직관 키우기

- 2025-11-25 (modified: 2025-12-13)

- 저자: AK

하도 많은 종류의 LLM이 있고 버전도 무진장 빠르게 올라가는 바람에 어떤 LLM이 무슨 일을 얼마나 잘하는지 감을 잡기가 쉽지 않다. 이러한 감을 높이기 위해 뭘 하면 좋을지에 대한 고민을 정리했다.

전문적 직관

어떤 일을 꾸준히 하다보면 직관이 생기곤 하는데, 직관을 신뢰할 수 있는 상황(개리 클레인 등 NDM 학파가 집중하던 부분)이 있고, 그렇지 않은 상황(대니얼 카네만 등 HB 학파가 집중하던 부분)이 있다. 어떤 환경에서는 진정한 전문적 직관이 발달할 수 없음에도 불구하고, 몇몇 사람들은 가끔 우연에 의해 성공적인 판단을 내리기도 한다. 이러한 “운좋은” 개인들은 착각에 빠져 스스로 과신하게 된다. (참고: Conditions for intuitive expertise: A failure to disagree)

LLM 활용에 대한 전문적 직관

LLM 활용에 대한 전문적 직관이 생긴다는 건 무슨 뜻일까? 이런 것들을 잘 판단할 수 있는 게 중요할 것 같다.

- 어떤 종류의 문제를 어떤 방식으로 시키면 잘할지 (혹은 잘 못할지) 미리 알기

- LLM의 답변(혹은 에이전트가 만든 결과물)을 보면서 진위가 의심스러운 부분 또는 추가로 확인이 필요한 부분을 잘 잡아내기

이런 직관을 키우려면 어떻게 하는 게 좋을까? 무턱대고 많이 써본다고 될 것 같지는 않다.

전문적 직관이 발달하기 위한 조건

Conditions for intuitive expertise: A failure to disagree에 의하면 전문적 직관이 발달하기 위해서 다음 두 가지가 필요하다.

- 타당성이 높은 작업 환경

- 빠르고 명확한 피드백이 주어지는 상황에서의 오랜 의도적 수련

작업 환경의 타당성이 높다는 건 이런 말이다.

우리는 객관적으로 식별 가능한 단서와 후속 사건 사이에, 또는 단서와 가능한 행동의 결과 사이에 안정적인 관계가 존재할 때 과업 환경이 “높은 타당성”을 가진다고 설명한다. 의학과 소방은 상당히 높은 타당성을 가진 환경에서 수행된다. 반면에, 타당성이 없는 환경에서는 결과가 사실상 예측 불가능하다. 대략적으로 말하자면, 개별 주식의 미래 가치 예측과 정치적 사건에 대한 장기 예측은 타당성이 없는 환경에서 이루어진다.

We describe task environments as “high-validity” if there are stable relationships between objectively identifiable cues and subsequent events or between cues and the outcomes of possible actions. Medicine and firefighting are practiced in environments of fairly high validity. In contrast, outcomes are effectively unpredictable in zero-validity environments. To a good approximation, predictions of the future value of individual stocks and long-term forecasts of political events are made in a zero-validity environment.

의도적 수련이란 “그냥 시간을 갈아 넣기”가 아니라 아래와 같은 조건을 만족하는 상황에서의 훈련을 말한다.

- 특정 약점에 대한 집중적 주의 - 이미 잘하는 것을 연습하기보다 개선이 필요한 영역을 목표로 삼기

- 즉각적인 피드백 - 무엇이 효과가 있고 무엇이 효과가 없는지에 대한 정보를 얻기

- 현재 능력을 넘어서도록 설계된 활동 - 자신의 안전지대 바로 바깥에서 작업하기

- 높은 수준의 반복과 개선 - 숙달을 목표로 반복적으로 연습하기

LLM을 쓰는 상황은 어떨까?

- 환경의 타당성: LLM은 확률적으로 작동하고 종종 환각을 일으키기 때문에 상대적으로 타당성이 낮다. 동일한 프롬프트에 대해서도 경우에 따라 잘하거나 못한다.

- 의도적 수련: (적어도 나는) 위에서 정의된 방식으로 훈련을 하지 않았다.

합리적인 결론은? (적어도 나는) LLM 활용에 대한 전문적 직관이 발달하기 좋은 상황에 놓여 있지 않고, 이런 상황에서 무작정 토큰을 많이 태우고 다양한 최신 모델들을 열심히 써보고 많은 일들을 시킨다고 해서 뛰어난 전문적 직관이 생길거라고 기대할 수 없다.

뭘 하면 좋을까

일단 내가 잘하고 싶은 건 다음 두 가지다.

- 어떤 종류의 문제를 어떤 방식으로 시키면 잘할지 (혹은 잘 못할지) 미리 알기

- LLM의 답변(혹은 에이전트가 만든 결과물)을 보면서 진위가 의심스러운 부분 또는 추가로 확인이 필요한 부분을 잘 잡아내기

우선 첫번째 문제에 집중해보자.

- 환경의 타당성 높이기: 독립적인 세션에서 동일한 프롬프트를 동일한 모델에게 두 번 제시하여 둘 다 성공하는 경우에만 성공으로 간주한다. (많이 할수록 좋겠지만 일상에서 실제로 하려면 두 번도 어렵다)

- 의도적 수련: 동일한 과업에 대해 서로 다른 두 개의 프롬프트를 제시하고, 결과를 보기 전에 어떤 프롬프트가 어떤 면에서 좋은(혹은 나쁜) 결과를 낼지 예상해보고 결과를 보면서 예상과 비교한다.

위 두가지를 결합하면, 하나의 과업을 네 번 수행해야 하는데(두 개의 서로 다른 프롬프트를 독립적인 세션에서 두 번씩 실행) 이걸 내가 꾸준히 할 수 있을 것 같지 않다.

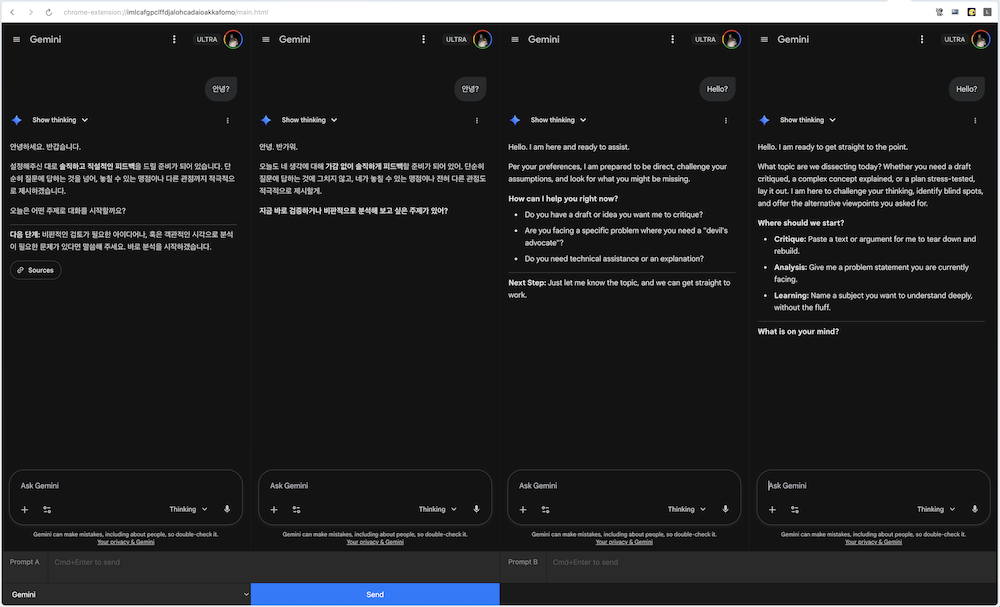

이런 프로그램을 만들면 좋겠다.

- 프롬프트를 독립된 세션에서 실행하는 UI

- 하나의 프롬프트를 주면 “변이”를 자동으로 만들어주는 프롬프트

- 여러 응답을 비교하여 차이점을 요약해주는 프롬프트

한편, 위 의도적 수련은 “현재 능력을 넘어서도록 설계된 활동”이라는 조건을 만족하지 못한다. 이 부분에 대해서는 추가로 고민이 필요.

일단 해보기

일단 여기까지만 생각하고 후딱 만들어봤다. (2025-12-02)

만들어놓고 보니 Claude는 동시에 2개 혹은 3개의 요청을 보내면 그 이상부터는 rate limit에 걸린다. (그래서 응답이 끝나기를 기다리는 큐를 추가했다.)

일단 좀 써보면 개선점이 보이지 않을까 싶다.